智谱华为联手!首个国产芯片训练多模态 SOTA 模型开源亮相

今天得给关注国产AI的朋友们同步个大消息——智谱AI和华为联手,正式开源了新一代图像生成模型GLM-Image!

最关键的是,这模型从数据处理到模型训练的全流程,都是基于昇腾Atlas 800T A2设备和昇思MindSpore AI框架完成的,堪称首个在国产芯片上实现全程训练的SOTA级多模态模型,国产算力底座的实力又一次被验证了!

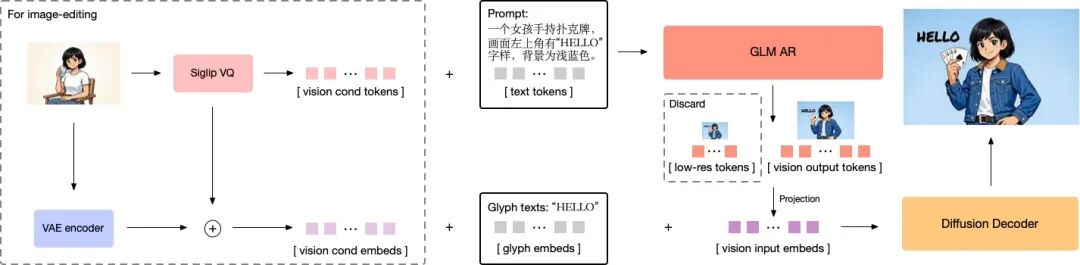

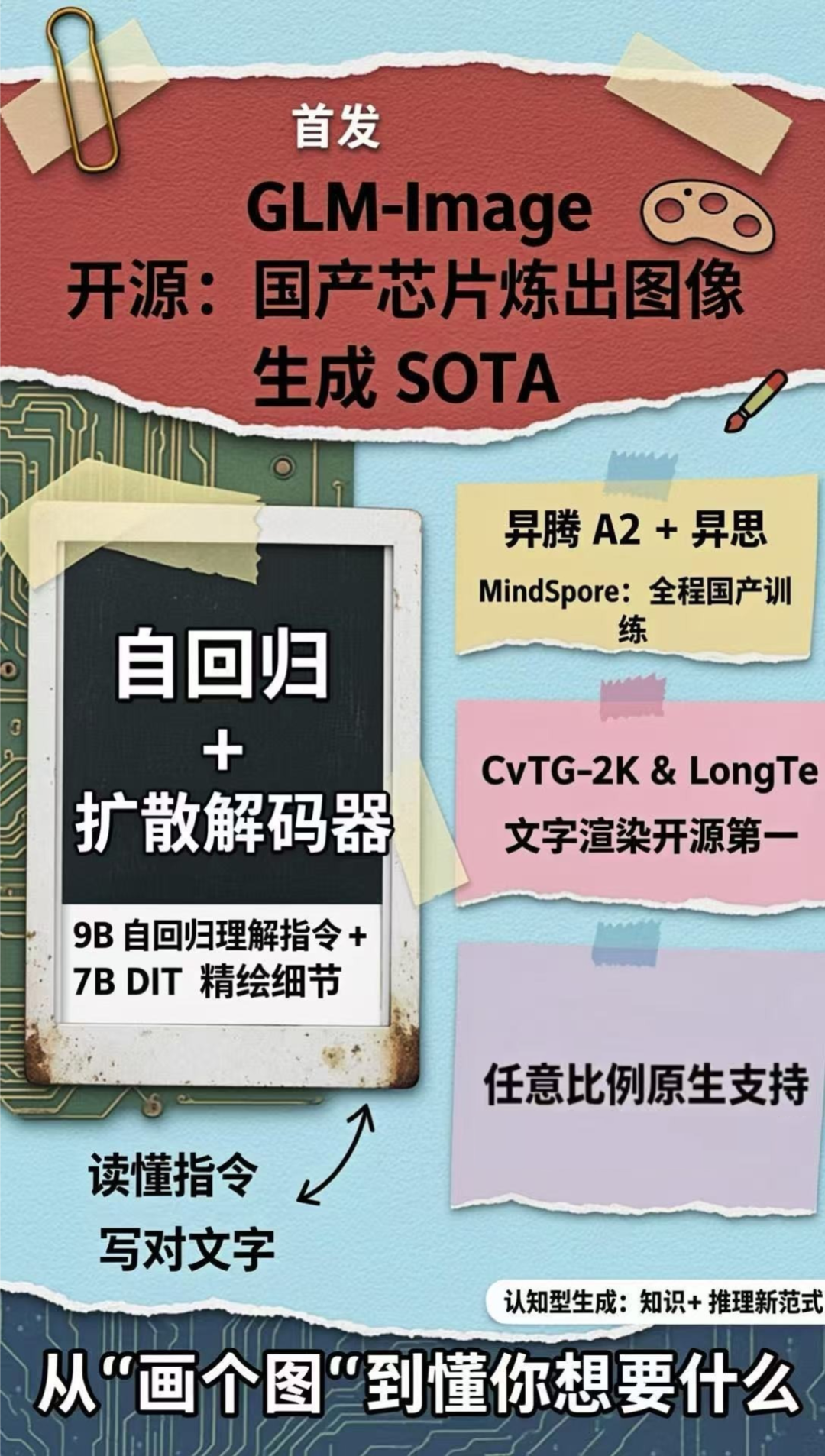

再说说模型本身的硬实力,GLM-Image用的是自主创新的“自回归+扩散解码器”混合架构,成功实现了图像生成和语言模型的深度联动。

这波操作可不是小尝试,而是朝着以Nano Banana Pro为代表的新一代“认知型生成”技术范式迈进的重要探索,看得出来行业内对AI生成的认知层面升级已经提上日程了。

我帮大家梳理了下这模型的核心亮点,每一个都很能打:

架构革新,直击认知型生成痛点:创新的“自回归+扩散编码器”混合架构太懂需求了,既能精准理解全局指令,又能把局部细节刻画到位。像海报制作、PPT可视化、科普图示这些知识密集型场景的生成难题,这下都有了解决方向,也为后续探索Nano Banana Pro那种“知识+推理”的认知型生成模型铺了路。

全流程国产化,国产AI的里程碑:模型的自回归结构基座完全适配昇腾Atlas 800T A2和昇思MindSpore框架,从数据预处理到大规模训练的全流程都打通了。这不仅是个模型开源,更重要的是验证了在国产全栈算力底座上,完全能训练出前沿的多模态模型,国产化进程又往前推了一大步!

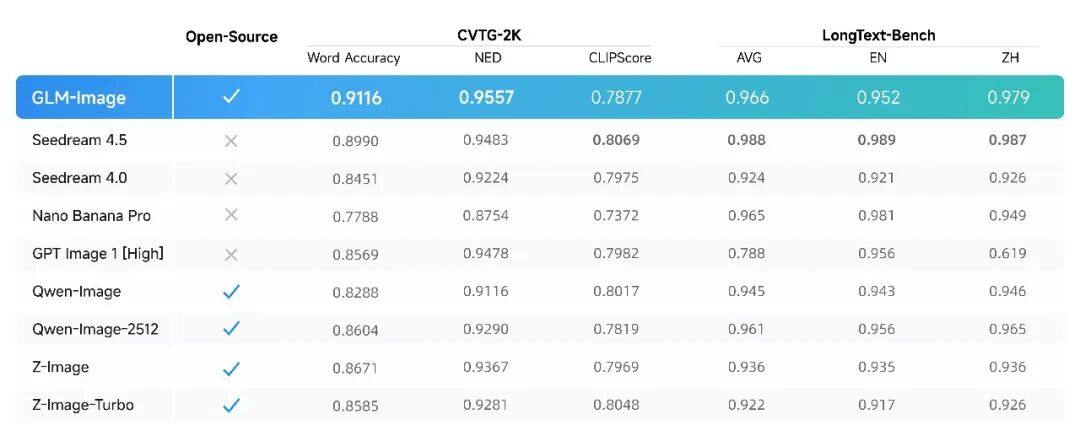

文字渲染实力拉满,开源赛道断层第一:在CVTG-2K(复杂视觉文本生成)和LongText-Bench(长文本渲染)这两个权威榜单上,GLM-Image直接拿下了开源赛道第一。尤其值得一提的是它的汉字生成能力,精准度和流畅度都很出色,对中文场景太友好了。

性价比炸裂,速度还将升级:用API调用生成一张图只要0.1元,这个成本对个人开发者和中小企业来说太友好了。而且官方说速度优化版本马上就要更新,后续使用体验还能再提升,期待值拉满!

深度拆解架构创新核心:精准解读指令,实现文本高效

近期图像生成领域的技术融合节奏明显加快,以Nano Banana Pro为代表的闭源图像生成模型,正持续推动图像生成与大语言模型的深度耦合,行业技术范式也随之发生关键进化——从单一的图像生成,升级为兼具世界知识储备与逻辑推理能力的“认知型生成”新范式。

这一范式的优势已在实际场景中充分显现,尤其在海报制作、PPT可视化、科普图绘制等知识密集型场景,以及高保真细节还原需求中,这类模型的表现堪称惊艳。

而在这一前沿赛道中,GLM-Image的推出无疑是开源领域的重要突破。

作为首个开源的工业表现级离散自回归图像生成模型,它不仅是对“认知型生成”技术范式的针对性探索,更向开源社区完整开放了该方向的技术路径与实践思考,为行业共建技术生态提供了关键抓手。

从技术架构来看,GLM-Image的核心创新点精准切中了行业痛点。

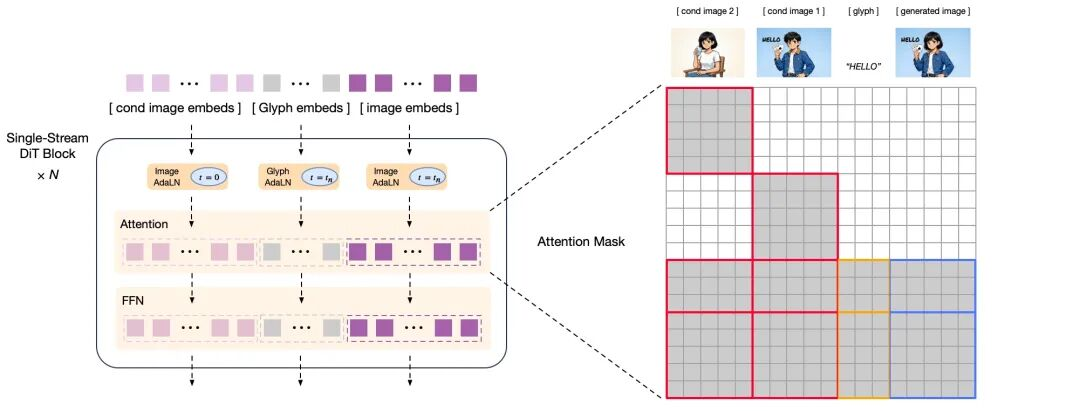

针对传统模型普遍存在的“理解复杂指令”与“精准绘制文字”难以兼顾的核心问题,它创新性地采用“自回归+扩散解码器”混合架构,通过双模型协同实现能力互补:其中9B规模的自回归模型依托语言模型底座优势,重点攻克指令语义理解的精准度与画面全局构图的合理性;7B规模的DiT扩散解码器则搭配Glyph Encoder文本编码器,专注于还原图像高频细节与文字笔画的精细度,从根源上改善了模型“提笔忘字”的行业通病。

另一大技术亮点在于多分辨率自适应能力。

GLM-Image通过优化Tokenizer策略,实现了对多种分辨率的原生适配,能够直接承接从1024x1024到2048×2048尺寸、任意比例的图像生成任务,无需额外重新训练,这一设计大幅降低了模型在不同场景下的应用门槛,提升了工业级落地的灵活性。

整体来看,GLM-Image以开源姿态切入“认知型生成”赛道,其混合架构设计与多分辨率适配方案,不仅解决了传统图像生成模型的核心痛点,也为开源社区探索该技术范式提供了可落地、可复用的实践范本,值得行业重点关注。

通用pipeline

解码器结构示意图

GLM-Image技术报告:https://z.ai/blog/glm-image

开源 SOTA堪称文字密集生成任务的效能利器

依托此前提出的架构创新方案,GLM-Image 在文字渲染领域的权威评测榜单中,成功斩获开源领域 SOTA(State-of-the-Art)桂冠,其文字生成精度的核心优势在两大核心榜单中得到充分验证。

首先聚焦 CVTG-2K(复杂视觉文字生成)榜单——该榜单的核心考核维度,在于评估模型在单幅图像内多区域并行文字生成的精准度。

在关键的多区域文字生成准确率维度,GLM-Image 以 0.9116 的 Word Accuracy(文字准确率)强势登顶,在开源模型阵营中稳居榜首;而在衡量文字匹配度的 NED(归一化编辑距离)指标上,该模型同样交出 0.9557 的高分答卷,这一数据直观印证了其生成文字与目标文本的高一致性,有效降低了错字、漏字等核心误差。

另一项核心评测 LongText-Bench(长文本渲染)榜单,则重点评估模型对长文本、多行文字的渲染精度。

该榜单覆盖招牌、海报、PPT、对话框等 8 类典型文字密集场景,且专门设置中英双语测试维度。

面对多场景、多语言的综合考验,GLM-Image 依旧表现亮眼,最终以英文 0.952、中文 0.979 的优异成绩,再度蝉联开源模型第一梯队头部位置。

首款基于国产芯片训练的 SOTA 模型重磅亮相

GLM-Image的推出,堪称国产计算生态深度探索与可行性验证的关键实践。

这款基于自回归结构的模型,从数据预处理阶段到最终的大规模预训练,实现了全流程在昇腾Atlas 800T A2设备上的闭环落地,为国产算力底座的实战验证提供了重要样本。

从技术实现路径来看,该模型深度依托昇腾NPU硬件算力与昇思MindSpore AI框架,项目团队针对性自研模型训练套件,通过整合动态图多级流水下发、高性能融合算子、多流并行等核心技术特性,完成了数据预处理、预训练、SFT(有监督微调)及RL(强化学习)全链路的端到端优化。

具体来看,其优化逻辑集中在三个核心维度:其一,通过动态图多级流水优化机制,对Host侧算子下发的关键环节进行流水化重构与高度重叠设计,有效突破了算子下发的性能瓶颈;其二,采用多流并行策略实现通信与计算的高效互掩,成功打破文本梯度同步、图像特征广播等核心操作中的通信壁垒,实现性能极致提升;其三,集成AdamW EMA、COC、RMS Norm等昇腾硬件亲和性的高性能融合算子,在保障训练稳定性的同时进一步释放算力潜力。

作为首个在国产芯片平台完成全流程训练的SOTA级多模态模型,GLM-Image的落地核心价值在于,充分验证了在国产全栈算力底座之上构建高性能多模态生成模型的技术可行性。

对于国内AI社区而言,这一实践无疑为挖掘国产算力深层潜力、构建自主可控的AI训练生态提供了极具参考价值的技术范本。

官方实测案例

接下来将从实测视角,深度探析其在复杂视觉文本生成这类实际应用场景中的性能表现。

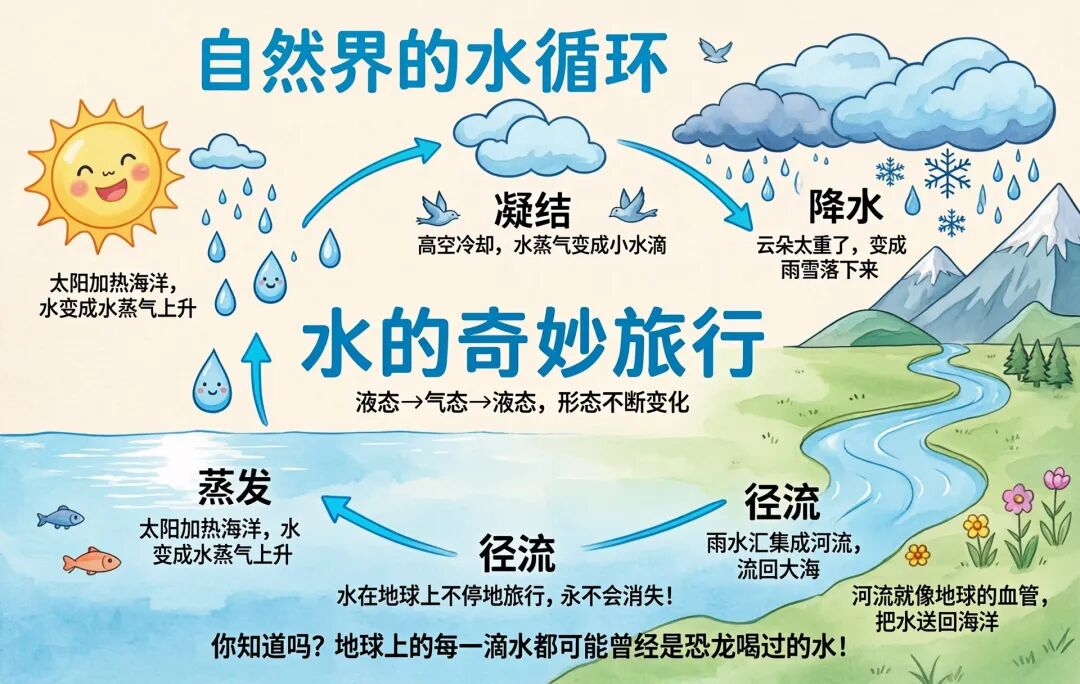

场景一:科普插画

GLM-Image 更擅长绘制包含复杂逻辑流程与文字说明的科普插画及原理示意图。

点击查看大图

场景二:多格图画

在生成电商图、漫画等多格图画时,GLM-Image能够保持风格和主体的一致性,并保障多处文字生成的准确率。

场景三:社交媒体图文封面

GLM-Image 适用于制作社交媒体封面及内容等排版复杂的图片,让您的创作更自由丰富。

点击查看大图

场景四:商业海报

GLM-Image 能够生成构图富有设计感、文字嵌入准确的节日海报与商业宣传图。

点击查看大图

场景五:写实摄影

在文字渲染以外,GLM-Image也同样擅长生成各种景别和尺寸的人像、宠物、风景、静物。

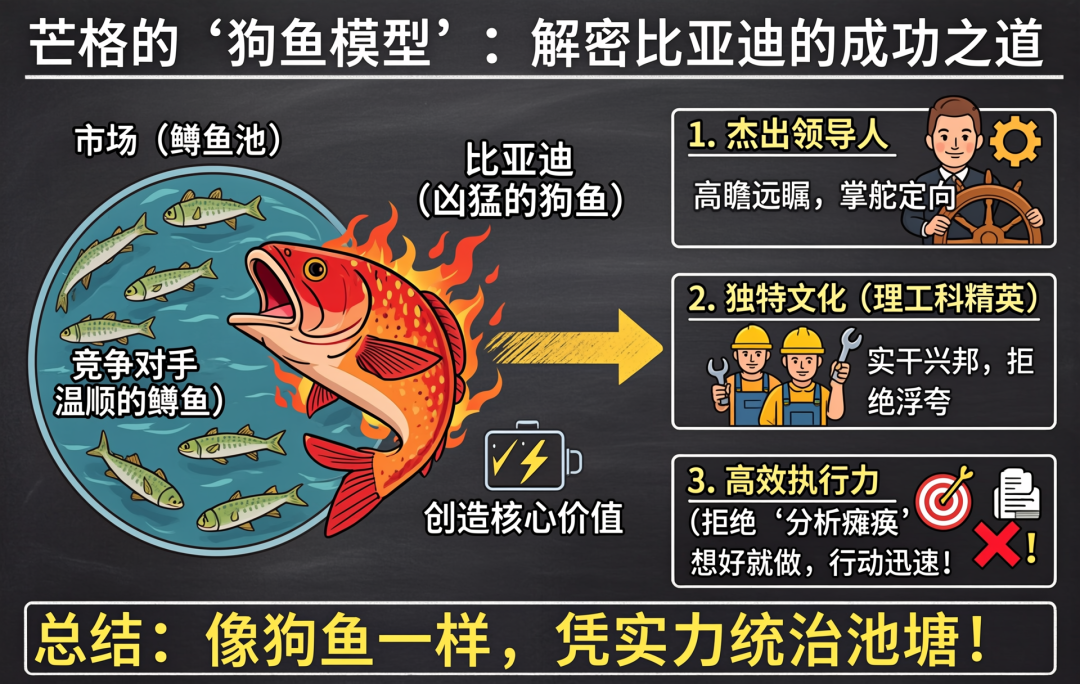

最后,用GLM-Image生成的一张图总结一下模型的核心要点。

琼ICP备2025054846号-2

琼ICP备2025054846号-2